在深度学习和人工智能领域,深度推理(DeepSeek)已经成为了提升计算机视觉、自然语言处理等多个领域性能的重要工具。要进行高效的深度推理,显卡(GPU)的选择至关重要。在本文中,我们将探讨深度推理对显卡有哪些具体要求,以及如何根据这些要求选择合适的显卡。

深度推理与显卡的关系

深度学习模型的推理过程通常涉及大量的矩阵计算和并行处理。GPU作为一种高度优化的并行处理单元,特别适合执行这些复杂的计算任务。不同于传统的CPU,GPU拥有成百上千的处理核心,能够同时处理成千上万个计算线程。在进行深度推理时,显卡的性能直接影响到模型的响应时间和处理效率。

关键性能指标

计算能力

计算能力是GPU进行深度推理时最为重要的指标之一。衡量GPU计算能力的常用单位是浮点运算次数(FLOPS),其中单精度浮点运算(FP32)和双精度浮点运算(FP64)是最为常见的评估方式。深度推理通常要求较高单精度浮点运算能力,因为大多数深度学习模型都使用FP32数据格式。

显存容量

显存(也称为VRAM)是显卡用来存储正在处理的数据的内存。深度学习模型可能会占用大量显存空间,特别是在处理高分辨率图片或大型数据集时。选择具有足够显存容量的显卡至关重要,以避免在推理过程中出现显存溢出的问题。

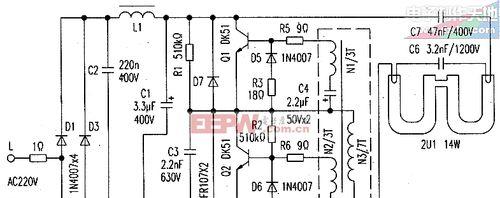

显存带宽

显存带宽是指显卡可以处理的数据速率,通常以GB/s为单位。高显存带宽能够确保数据快速传输至GPU核心,提升整体处理效率。对于实时或接近实时的深度推理任务,高显存带宽显得尤为重要。

架构与优化

随着深度学习算法的不断进步,GPU制造商也在不断推出针对深度学习优化的新架构。NVIDIA的Turing和Ampere架构,以及AMD的RadeonRX系列,都针对深度学习计算进行了优化。在选择显卡时,考虑其架构是否支持最新的深度学习技术,如TensorCore等加速器,是非常重要的。

软件兼容性与生态

深度学习框架和工具生态也是选择显卡时必须考虑的因素。NVIDIA的CUDA平台提供了广泛的深度学习库和工具支持,如cuDNN和TensorFlow。确保你的显卡与当前流行的深度学习框架兼容,将有助于简化开发流程和提升开发效率。

如何根据需求选择显卡

预算与性能需求

明确你的预算范围和深度推理任务的性能需求。对于入门级应用,中高端的GPU,如NVIDIA的GTX16系列,可能已经足够。对于更加专业和高负载的深度学习项目,可能需要投资于更高端的GPU,如RTX30系列或专业级别的Quadro/Titan系列。

确定模型复杂度

深度学习模型的大小和复杂度会影响显存容量的需求。对于复杂的模型,可能需要选择具有更大显存的显卡。使用BERT这类大型语言模型进行文本推理,就需要至少16GB甚至更多显存的显卡。

评估并行处理需求

如果任务需要处理大量的小型数据集,那么计算能力更加重要。如果你需要同时运行多个深度学习模型,那么更多的CUDA核心将大有帮助。

考虑未来升级与维护

技术发展迅速,选择时不仅要考虑当前的需求,还要预见未来可能的扩展和升级需求。选择具有良好软件生态和社区支持的显卡品牌,能够确保未来在技术升级时的平滑过渡。

结语

深度推理对显卡的要求主要集中在计算能力、显存容量和带宽、架构优化以及软件生态等方面。选择合适的显卡需要根据预算、模型复杂度、并行处理需求以及未来的升级维护等因素综合考虑。只有选对了显卡,才能保证深度推理工作的高效与顺畅,从而在深度学习的道路上迈出坚实的步伐。

通过以上所述,希望您能够对深度推理所需的显卡性能有一个全面的了解,并在实际选购时能够做出明智的决定。无论您是深度学习的研究者、开发者还是爱好者,这篇文章都为您提供了一个全面的参考指南。